Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

Tags

- fake jwt

- reids

- RedirectService

- hbase 저장공간 설정

- Loki 로그

- 플루터

- 티스토리챌린지

- formik

- intellij

- 논블록킹 성능

- Ingress Controller Fake

- jsonMarshaller

- LPOS

- R2DBC Paging

- 7879

- 핀포인트

- 오블완

- pinpoint 2.5.3

- jar 배포

- 월급루팡 일지

- OIDC

- 노드간 통신

- save/update

- Armeria

- nGinder

- 애자일 싫타

- pinpoint

- UnsupportedOperationException

- ㅉ때

- 개발 어렵당.ㅠ

Archives

- Today

- Total

대머리개발자

랭체인 적용해서 서비스 해보자. 본문

728x90

파일SUN!! 조으다.

from langchain_ollama import OllamaLLM

# model

ollama = OllamaLLM( base_url='http://localhost:11434', model="llama3-bllossom" )

# chain 실행

print(ollama.invoke("주식을 잘하려면 어떻게 해야 하나요?"))

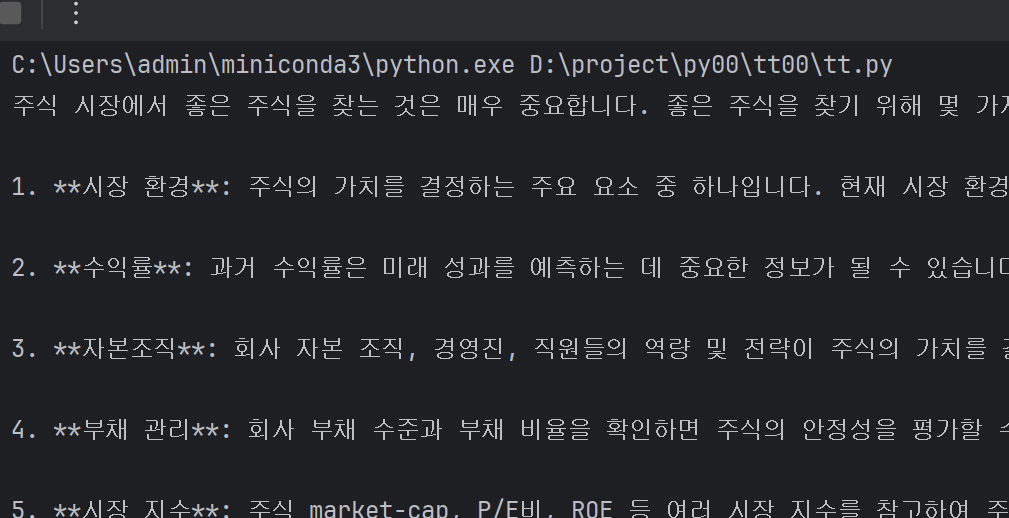

>> 응답!! 대에충 콘솔이랑 비슷하게 나온다.

영어로 질문하면 영어로 답변 한다.

무조건 답변을 한글로 하려면 간단하다. 질문에 앞 문장에서 "한국어로 답변해주세요" 하면 된다.

필터의 느낌으로. ㅎ

before_prompt = "한국어로 답변하세요!"

# chain 실행

print(ollama.invoke(before_prompt + " how good stocks "))

deep 하게 공부한다면 정말 끝도 없겠다.

일단 전체적으로 맛만 보자.

https://github.com/teddylee777/langserve_ollama

GitHub - teddylee777/langserve_ollama: 무료로 한국어🇰🇷 파인튜닝 모델 받아서 로컬 LLM 호스팅. LangServe

무료로 한국어🇰🇷 파인튜닝 모델 받아서 로컬 LLM 호스팅. LangServe, Ollama, streamlit + RAG - teddylee777/langserve_ollama

github.com

728x90

'개발이야기 > AI' 카테고리의 다른 글

| 무료 임베딩 기술 검토 및 TEST (0) | 2025.02.19 |

|---|---|

| deepseek - 오호... (0) | 2025.02.17 |

| 올라마 API 장착하기. (1) | 2025.02.07 |

| 올리마(Ollama) 일단 그냥 설치 해보자. (0) | 2025.02.05 |

| 개인형, 맞춤형 AI - 인트로 (2) | 2025.01.22 |